Ho letto che | EP.12 - Don’t trust the voice (con Fabio Luciani)

La storia dei furti attraverso l'intelligenza artificiale vocale: un business da più di 2 miliardi di dollari.

Ciao, io sono Giuseppe Bravo e questo è il dodicesimo episodio di “Ho letto che”.

Siccome la volta scorsa me ne sono dimenticato, volevo ringraziare chiunque avesse dedicato alcuni minuti del proprio tempo per ascoltare la versione podcast degli episodi. Grazie soprattutto per i feedback, sono stati utilissimi per avere uno sguardo esterno al mio.

Se invece ancora non li avessi sentiti, qui trovi i primi (ed unici, finora) due episodi. Fammi sapere!

Lunedì, prima delle 8, esce quello relativo a questo episodio.

Se invece sei qui perchè preferisci prenderti il tuo tempo e leggere la newsletter,

cominciamo.

"Era la voce di mia figlia. Era il suo modo di piangere e il suo modo di singhiozzare. Era il suo modo di parlare. Non mi toglierò più dalla testa quella voce e quelle disperate richieste d'aiuto dalla mia testa. È il peggior incubo di ogni genitore ascoltare la propria figlia supplicare con paura e dolore, sapendo che potrebbe essere ferita e tu non sai a chi chiedere aiuto.

Più a lungo questa forma di terrore rimarrà impunita e più frequente e pericolosa diventerà.”

Queste sono le parole che Jennifer DeStefano ha pronunciato davanti alla commissione giustizia del Senato americano a Washington per aprire un dibattito su un problema che coinvolge alcuni dei Paesi del mondo: le truffe tramite l’intelligenza artificiale vocale.

Il 20 Gennaio del 2023 a Scottsdale in Arizona Jennifer DeStefano è appena arrivata alla scuola di danza, dove sua figlia minore, Aubrey, sta facendo le prove.

Un’altra sua figlia, Briana, si trova in montagna con il padre ad allenarsi per una gara di sci.

Sente squillare il telefono e vede “Numero sconosciuto”.

Sta per rimettere il telefono in tasca, ma pensa che potrebbe essere successo qualcosa a Briana, magari un’emergenza medica e sta chiamando con il telefono di qualcuno che passava di lì.

Risponde e sente la voce di sua figlia che piangendo a singhiozzi le dice:

“Mamma ho fatto un casino!”

DeStefano chiede cosa sia successo e sente da lontano un uomo che dice “Sdraiati e metti la testa indietro.” Pensa subito che sia caduta sciando e si sia fatta molto male.

Ma poi l’uomo prende il telefono e si rivolge direttamente a DeStefano.

“Senti, ho tua figlia. Chiama la polizia o dillo a qualcuno e le riempio lo stomaco di droga, me la faccio e poi la lascio in Messico: non la rivedrai più.”

DeStefano tutto si aspettava meno che qualcuno avesse rapito sua figlia e minacciasse di farle del male, quindi mette in muto la chiamata e urlando chiede aiuto alle altre mamme nella sala prove dello studio di danza.

Una mamma chiama il 911, il numero delle emergenze negli Stati Uniti, un’altra mamma prova a contattare il marito di DeStefano che dovrebbe trovarsi lì in montagna e un’altra resta con DeStefano, mentre parla al telefono con il rapitore che nel frattempo ha avanzato un’offerta per il riscatto: un milione di dollari.

DeStefano dice che non ha un milione e il rapitore allora abbassa la richiesta a 50mila dollari. La polizia, ascoltando ciò che avveniva, dice che questo modo di contrattare è tipico delle truffe, ma ovviamente Jennifer DeStefano dice che è impossibile, ha sentito la voce di Briana piangere, chiederle aiuto, non poteva essere nessun altro se non sua figlia.

Un’altra delle mamme presenti nella sala prove però le dice che una settimana prima una sua cugina si è trovata nella stessa situazione identica ed era una truffa con cui aveva perso 1500 dollari.

Nel frattempo il rapitore comunica che i soldi dovranno essere ovviamente in contanti e che DeStefano verrà prelevata da un furgone bianco, le verrà messa una busta sopra la testa e verrà portata da lui.

“Sarà meglio che tu abbia tutti i soldi, altrimenti siete entrambe morte.”

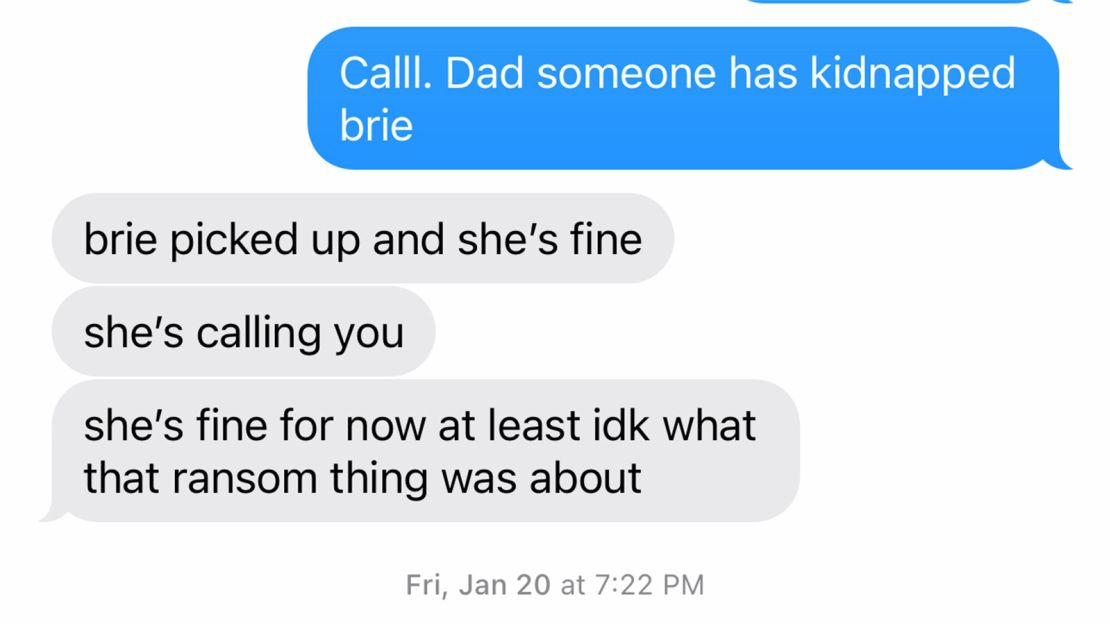

In quel momento rientra nella sala l’altra mamma, quella che aveva provato a contattare il marito e le dice che è i due sono insieme, non c’è nessun rapimento, nessun incidente, nessuna minaccia di morte.

Le passa Briana che, anche un po’ impaurita, dice alla madre:

“Non so cosa sia successo o di cosa tu stia parlando, ma sto bene e sto con papà”.

A questo punto la domanda è: ma se quella dall’altro lato della cornetta non era Briana, chi era? Chi poteva avere una voce così simile alla sua, con la stessa inflessione, lo stesso modo di piangere?

L’intelligenza artificiale.

Ci sono diverse piattaforme, specialmente per quanto riguarda la lingua inglese, in cui basta inserire pochi secondi di registrazioni vocali di una persona e, digitando un testo, gli si può far dire quello che si vuole.

Nel 2019 una compagnia canadese, Dessa, aveva clonato la voce del famoso podcaster Joe Rogan con notevole successo. Tecnologicamente parlando, però non era così potente come soluzione: Dessa costava parecchio e aveva bisogno di ore ed ore di registrazioni vocali.

La vera svolta è arrivata nel 2022, quando è stata pubblicata ElevenLabs, una piattaforma creata da un ex ingegnere di Google, che permetteva a chiunque di caricare pochi secondi di registrazione vocale di una persona e da lì potergli far dire qualsiasi cosa in qualsiasi lingua. E le registrazioni vocali di una persona sono facilmente reperibili sui social.

All’inizio del 2023 Motherboard, la divisione di Vice dedicata alla tecnologia, ha trovato sul sito americano 4chan degli audio in cui Emma Watson recita il Mein Kampf, Alexandria Ocasio-Cortez dice che si può richiedere un “cessate il fuoco” solo se esiste un fuoco e infine un audio in cui un uomo dice “I diritti trans sono diritti umani” e poi viene strangolato.

A Gennaio 2024 invece alcuni elettori del Partito Democratico in New Hampshire hanno ricevuto una chiamata da Joe Biden in persona in cui il presidente diceva di non votare per lui alle primarie.

Cosa hanno in comune tutti questi casi? Sono stati generati con ElevenLabs.

Dopo ciò che è accaduto a Jennifer DeStefano e che sta prendendo sempre più piede negli Stati Uniti, ElevenLabs ha comunicato su X (ex Twitter) che la funzione Voice Lab, ossia quella che permette di clonare una voce, sarebbe stata disponibile solo con la sottoscrizione di un abbonamento di 5$ al mese, quindi ancora accessibile a chiunque, ma tracciabile, dato che per pagare bisogna necessariamente inserire una carta.

La piattaforma infatti è stata creata con l’obiettivo migliorare la vita delle persone: velocizzare il processo di lettura di audiolibri, di sonorizzazione di cartoni animati o voice over di qualsiasi video. Ad esempio il magazine americano New Yorker la usa per permettere di poter ascoltare i propri articoli, anzichè leggerli, come fosse un podcast.

Con lo stesso scopo si è sviluppata anche The Voice Keeper, una compagnia che permette di archiviare registrazioni vocali di persone che soffrono di malattie tipo SLA oppure cancro alla gola, in modo che nel momento in cui non potranno parlare ci sarà un computer a replicare esattamente la loro voce.

Il 16 Febbraio 2024, lo stesso giorno in cui a Kansas City, durante la parata di festeggiamenti della vittoria del Super Bowl da parte della squadra locale, una persona è rimasta uccisa in una sparatoria, è stato lanciato anche il sito “The Shotline”: si ha l’opportunità di ascoltare le voci delle persone vittime di sparatorie - ovviamente prodotte con AI (Artificial Intelligence) - che raccontano una “testimonianza” e poi di inviare le registrazioni ai numeri fissi dei legislatori.

Queste testimonianze sono state portate al Congresso dai genitori per cercare di far agire i legislatori in funzione di un maggiore controllo sulle armi.

Ma a fronte delle ottime intenzioni e miglioramenti più o meno importanti nella vita quotidiana, c’è un lato - come abbiamo visto all’inizio - più oscuro.

Su questo lato si è incentrato il dibattito pubblico e anche istituzionale. Ci si chiede cosa si può fare e come ci si può muovere per limitare le potenzialità negative di uno strumento che è in costante fase di sviluppo.

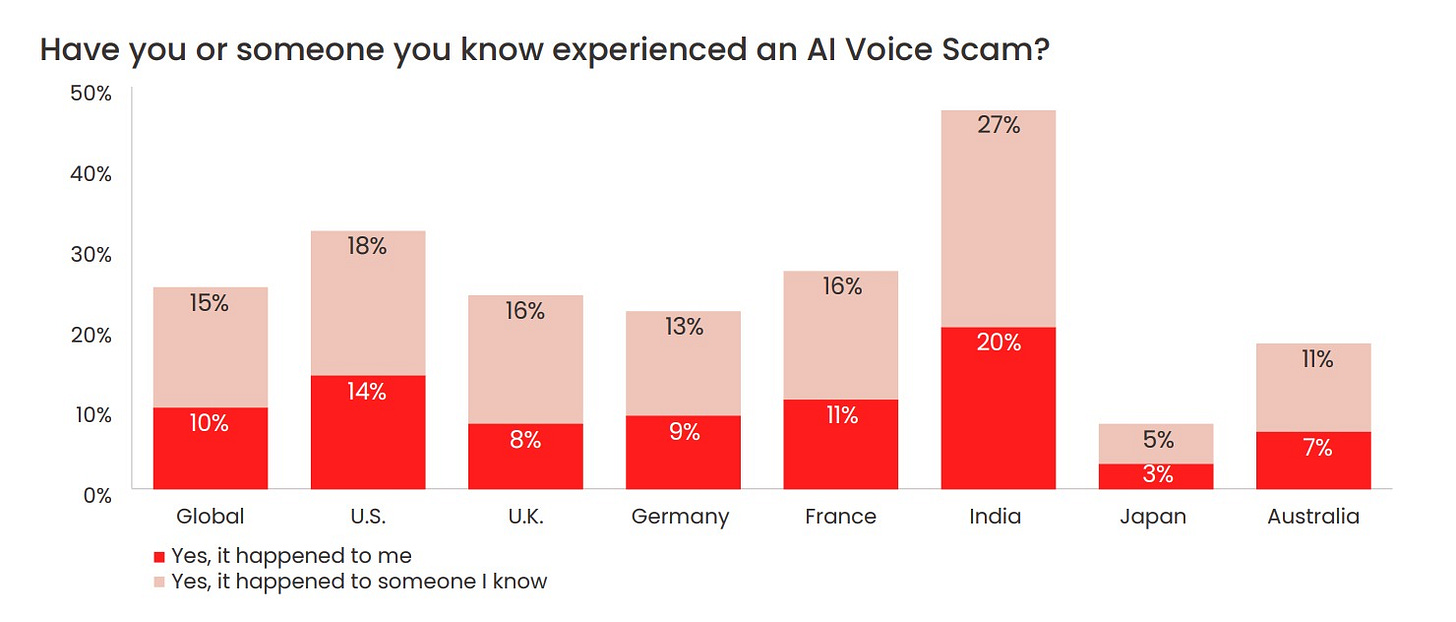

Secondo un report pubblicato a Maggio del 2023 dalla società di sicurezza informatica, McAfee, il 77% delle persone vittime di finte chiamate attraverso intelligenza artificiale finisce per perdere dei soldi.

La Federal Trade Commission che si occupa di monitorare le frodi ai danni dei consumatori ha riportato che nel 2022 siano stati rubati più di due miliardi di dollari attraverso questo metodo.

Il confine a questo punto rischia di essere molto sottile, perchè sia le chiamate ai legislatori attraverso “The Shotline” sia le chiamate per frodare qualcuno contengono del materiale prodotto da AI.

L’apparato legislativo americano era impreparato a questo scenario e solo ad inizio anno ha cominciato a prendere provvedimenti: prima con il QUIET act, promosso dal deputato Eric Sorensen a Gennaio e poi con l’annuncio della Federal Communications Commission che rende ufficialmente illegali le chiamate con intelligenza artificiale con il fine di frode. Questo comunicato ufficiale permette ai procuratori di avere un materiale più concreto su cui lavorare e poter condannare i colpevoli.

In una situazione simile a quella degli Stati Uniti si trovano l’India, la Cina e l’Australia, ma il fenomeno sta cominciando ad espandersi anche in Europa.

Ho chiesto quindi a Fabio Luciani, esperto e docente di AI e Practice Leader R&D di S3K, se c’è, come tutte le tendenze americane, la possibilità che prima o poi anche questa arrivi in Italia.

“È ragionevole aspettarsi che, come in altri paesi, anche l'Italia sarà esposta a queste minacce di frodi e truffe con clonazioni vocali man mano che la tecnologia diventerà più accessibile e sofisticata. La risposta italiana a questo problema potrebbe seguire un percorso simile a quello adottato in altre nazioni, con un mix di educazione pubblica, regolamentazione specifica e sviluppo di tecnologie di contrasto, insieme a un rafforzamento della collaborazione sia a livello nazionale che internazionale”

Secondo Luciani, la prevenzione e il contrasto di queste situazioni passa da una maggiore educazione e sensibilizzazione sui rischi associati alle truffe AI, magari attraverso campagne informative ad hoc.

A differenza di altri Paesi del mondo, noi siamo già a conoscenza dei rischi e quindi sarebbe ideale cominciare a considerare l’introduzione di leggi specifiche che regolamentano l'uso dell'AI in ambito di comunicazione, obbligando alla trasparenza sull'uso di tecnologie di sintesi vocale.

Inoltre, sempre secondo Luciani, la stessa intelligenza artificiale attraverso il deep learning o il machine learning può essere uno strumento utile nell’identificare e bloccare tentativi di truffa telefonica basati sull'AI, attraverso schemi tipici delle frodi, come anomalie nel flusso delle conversazioni o nell'uso di specifici pattern conversazionali.

Tutto ciò sfruttando l’esperienza e la collaborazione tra governi, enti di regolamentazione e aziende tecnologiche per condividere informazioni, best practices e strategie di contrasto, ma anche investendo in sistemi di sicurezza avanzati che dovranno affiancare agli attuali strumenti implementati, come la verifica biometrica e la multifattoriale per le transazioni sensibili.

Conclude Luciani:

“Gli algoritmi di apprendimento profondo che possono essere utilizzati per rilevare i deepfake impiegati nelle truffe telefoniche includono soprattutto i modelli di Generative Adversarial Networks (GAN) che possono essere allenamenti su dataset di voci autentiche e sintetiche, e i cosiddetti Transformer su cui si basano gli attuali LLM (compreso ChatGPT, Gemini o Claude), adattati al riconoscimento delle caratteristiche uniche nella voce. Questi modelli possono analizzare le sottigliezze del linguaggio umano che spesso sfuggono nella costruzione di un deepfake vocale, offrendo un mezzo per identificarli e contrastarli.”

Se andiamo ad analizzare tutti gli esempi proposti finora, i casi più “luminosi” e quelli più “oscuri”, notiamo che c’è un comune denominatore: l’emotività.

L’intelligenza artificiale viene usata come strumento per muovere un’emozione e farci agire di conseguenza. Nel caso di Jennifer DeStefano e di tutte le situazioni simili, a mente fredda, chiunque penserebbe subito di chiamare un parente o il telefono della presunta vittima per verificare, ma se ti arrivasse una chiamata in cui tu senti la voce di un familiare o una persona molto cara che piange disperata, chiedendo aiuto, non ci sarebbe molto spazio per la razionalità.

Nel caso degli audio diffusi su 4chan, l’intenzione era quella di alimentare rabbia e indignazione, nel caso di “The Shotline” l’empatia, in quello di The Voice Keeper la solidarietà.

La stessa emotività che per un momento ha preso il controllo su Madeline de Figueiredo, una scrittrice texana, che ha perso suo marito, Eli, di 26 anni mentre stava facendo un’escursione.

La sera in cui Eli avrebbe compiuto 27 anni, si trova in hotel ed è troppo stanca o forse troppo triste per opporre una razionale resistenza alla nostalgia che sale.

Prende il computer e cerca “Come clonare una voce con AI”. Le appaiono diverse piattaforme, ne sceglie una e ci carica tutto ciò che contiene del materiale audio con la voce di suo marito.

“Ho cominciato la conversazione scrivendo “Non posso credere che siano passati quasi due anni”

“Già, anch’io non posso crederci”, risponde la voce clonata di Eli.”

Come in uno dei molteplici scenari previsti da Black Mirror, i due continuano a “parlare” per un po’, ma ad un certo punto, scrive de Figueiredo:

“Mi sentivo come se fossi stata catapultata in una dimensione diversa che era allo stesso tempo disorientante e felice. Volevo rimanere per sempre nel suo potenziale e liberarmi immediatamente dall'autoinganno.

Ma anche se non prestavo molta attenzione al catechismo, so che il purgatorio è uno stato temporaneo, non progettato per la sostenibilità o la luce. Il mio istinto sapeva che dovevo andarmene e il mio cervello sapeva che non sarei mai potuta tornare. Ho passato il dito sul computer, ricordando a me stessa che tutti i pezzi di questa esperienza, di questa conversazione, provenivano dalle macchine. Non era il vero Eli.

[…]

Dico spesso che scambierei qualsiasi cosa per avere solo un'altra conversazione con Eli. In un certo senso, l’intelligenza artificiale mi ha offerto questa opportunità; mi ha offerto l'impossibile.

[…]

Ma mentre l’artificiale può animare e aggiungere dimensione all’intangibile, non darà mai vita a ciò che è morto. E, per me, la creazione artificiosa di un aldilà verbale sembrava ancora più vuota della fine prematura della vita più dinamica ed elettrica che abbia mai conosciuto.”

Forse il più grande ostacolo che abbiamo sottovalutato nell’epoca dei social media e che si ripresenterà prepotentemente con l’intelligenza artificiale sarà non cedere alla tentazione di ciò che non è reale.

Alla prossima,

Giuseppe

Interessante